Quelle: kentoh – Fotolia

Ausgleichsenergiekosten senken durch Prognose-Benchmark

Der Ausbau der erneuerbaren Energien erfordert es, den Verbrauch an das schwankende Energieangebot anzupassen. Dafür muss der erwartete Verbrauch möglichst akkurat vorhergesagt werden. Welche Methoden und Tools die Prognosegenauigkeit erhöhen, zeigt ein Benchmark, den Forscherinnen und Forscher am Fraunhofer IPA entwickelt haben.

Bei der Stromversorgung müssen sich die Summen der erzeugten und der bezogenen Energie zu jedem Zeitpunkt ausgleichen [1], um die Netzfrequenz stabil zu halten und damit Versorgungsengpässe zu vermeiden. Die Speicherkapazität in Batterien ist begrenzt, ebenso wie die Möglichkeit Strom über Trassen in andere Gebiete zu leiten. Somit ist die für einen Bilanzraum zuzukaufende oder abzugebende Strommenge möglichst genau zu planen, was neben der Prognose der Erzeugung eine Kurzfrist-Lastprognose (Prognose des Verbrauchs) erfordert. Anwender der Lastprognose sind Verteilnetzbetreiber für die Planung von Regelreserven oder Energieversorger für das Fahrplanmanagement [1]. Mit der Zunahme der erneuerbaren Energien schwanken die Strompreise stärker. Dies schafft Anreize für Konsumenten, durch Energieflexibilität in Verbindung mit dynamischen Stromtarifen Strom zu möglichst günstigen oder gar negativen Preisen zu beziehen [2]. Somit steigt auch die Relevanz der Lastprognose im Energiemarkt der Zukunft.

Bei der Erstellung der Prognose besteht ein hohes finanzielles Risiko, da Abweichungen zu Strafzahlungen führen, etwa in Form von Ausgleichsenergie, oder zum Ein- oder Verkauf der falsch geplanten Strommengen zu teils teuren Preisen im Intraday-Handel führen. Aufgrund der Vielzahl der Anwender und der hohen Anforderungen an die Prognosegenauigkeit besteht eine große Auswahl an Anbietern für Lastprognose-Software [3]. Welches Software-Tool sich eignet, hängt von den Anforderungen an die Lastprognose ab. Die Prognosegüte ist nicht nur vom Prognosealgorithmus abhängig, sondern auch von der Datenlage [4] und letztendlich vom jeweiligen Lastgang [5]. Daher ist die eigene Prognosegenauigkeit stets zu prüfen und mit anderen Tools zu vergleichen. Der Benchmark beschreibt eine systematische Vorgehensweise zur Einordnung der Genauigkeit bestehender Prognosen gegenüber dem Stand der Technik, wodurch Verbesserungspotenziale ermittelt werden können.

Übersicht über Prognosemethoden und Tools

Die Lastgangprognose für größere Kunden oder Kundengruppen mit einer registrierenden Leistungsmessung, die typischerweise ab einem Jahresverbrauch von 100.000 Kilowattstunden installiert ist [6], erfolgt mit historischen Messdaten. Dafür werden referenzbasierte Methoden eingesetzt wie Fortschreibungsverfahren, der gleitende Durchschnitt oder das Vergleichstageverfahren. Bei Letzerem werden Lastprofile für Tagtypen gebildet, die zwischen Werktagen und dem Wochenende sowie den Jahreszeiten unterscheiden. Dieses Verfahren eignet sich wegen des zyklischen Verhaltens von Lastgängen mit niedrigerer Last während der Nacht und am Wochenende und mit saisonalen Unterschieden, die durch menschliche Aktivitäten und klimatische Einflüsse bedingt sind [7, 8].

Statistische Prognosemodelle unterscheiden sich von den referenzbasierten Verfahren durch Modellparameter, die durch die Modellkalibrierung bestimmt werden. Einfache statistische Methoden sind die univariaten Zeitreihenmodelle, die zur Prognose lediglich Lastwerte der Vergangenheit verwenden, oder Regressionsmodelle mit externen Einflüssen, zum Beispiel die Temperaturregression [8]. Methoden des maschinellen Lernens werden zunehmend verwendet, was in deren Eigenschaft komplexe Zusammenhänge in hochdimensionalen Eingangsdaten erkennen zu können begründet ist. Die Digitalisierung und die steigende Rechenleistung tragen zur gesteigerten Beliebtheit künstlicher neuronaler Netze und anderer Modellen des maschinellen Lernens bei [8, 9].

Zur kommerziellen Vermarktung von Lastprognosen werden geeignete Prognosemodelle in eine Softwareumgebung implementiert. Die Umsetzung der Methoden erfordert Erfahrung und Branchenwissen. Dadurch hängt die Qualität der Prognose von der Anbieterwahl ab [3]. Bei der Bereitstellung von Prognosen ist zwischen Dienstleistern und Systemanbietern zu unterscheiden. Dienstleister stellen die Prognosedaten, die mit ausgewählten Modellen berechnet werden, bereit, ohne das Prognosetool als Softwarepaket zur Verfügung zu stellen. Systemanbieter dagegen stellen für größere Kunden oder Dienstleister Prognosetools bereit, die über eine graphische Benutzeroberfläche und über unterschiedliche Prognosemodelle verfügen. Die meisten Anbieter verwenden künstliche neuronale Netze, einzelne Anbieter berücksichtigen auch klassische Prognosemodelle [3].

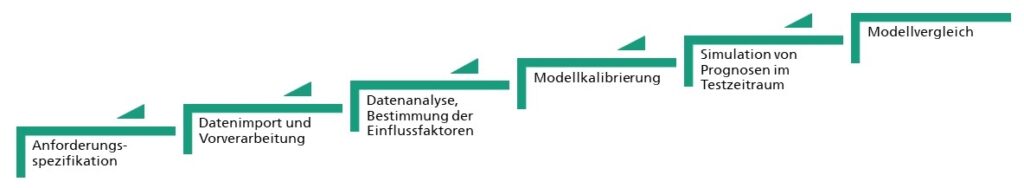

Vorgehensweise des Benchmarks

Beim Benchmark von Prognosemodellen sind zunächst die Anforderungen an die Prognose zu definieren. Die wichtigsten Festlegungen sind der Prognosezeitraum und die Häufigkeit der Aktualisierung der Prognose. Zudem ist bei der Kalibrierung des Prognosemodells zu berücksichtigen, mit welcher zeitlichen Auflösung Leistungsmesswerte vorliegen und wie häufig neue Messwerte eintreffen. Letztlich ist zu prüfen, ob die Prognose mit dem Top-down-Ansatz, also als Summenprognose für eine Gruppe von Marktallokationen erstellt werden soll, oder Einzelprognosen aufsummiert werden (Bottom-up-Ansatz) [3].

Im nächsten Schritt sind die Datenquellen zu identifizieren. Bestehen Daten von mehreren Lastgängen, ist zunächst eine Gruppe repräsentativer Lastgänge auszuwählen, für die der Benchmark exemplarisch durchgeführt wird. Neben Lastgangdaten können Kontextdaten, wie beispielsweise Produktionsdaten bei Industrieunternehmen, zu genaueren Prognosen führen [4, 5]. Es gibt zudem einige Anbieter, die sowohl historische Wetterdaten als auch Wetterprognosen bereitstellen, mit Unterschieden bezüglich der Anzahl der Wetterstationen, zeitlichen Auflösung, Prognosehorizonte und der Messgrößen [3]. Alle Daten sind anschließend zu importieren. Die Datenvorverarbeitung umfasst das Füllen von Datenlücken, die aus Ausfällen des Messsystems resultieren.

Neben der Prognosegenauigkeit sind weitere Kriterien zu betrachten, um zu entscheiden, ob ein Prognosemodell geeignet ist und welche Daten berücksichtigt werden. Komplexere Prognosemodelle und mehr Eingangsdaten bieten häufig Potenzial, die Genauigkeit gegenüber einfachen Verfahren zu steigern, erhöhen jedoch die aufzuwendende Rechenleistung und den Bedarf an Speicherplatz [8, 9], und dadurch die IT-Kosten. Ebenso ist der Berechnungsweg und somit die Ergebnisgenauigkeit in komplexeren Modellen, wie beispielsweise künstlichen neuronalen Netzen, schwierig nachzuvollziehen, vor allem wenn diese aus einer Vielzahl an vernetzten Berechnungseinheiten bestehen. Somit ist festzulegen, ob die Erklärbarkeit der Modelle ein entscheidendes Bewertungskriterium ist und ob dieses durch das betrachtete Modell gegeben ist. Schließlich bietet eine Kostenabschätzung, die Investitionen, variable Kosten und Erlöspotenziale je nach Prognosegenauigkeit betrachtet, eine Entscheidungsgrundlage für die Wahl eines Prognosemodells.

Fazit

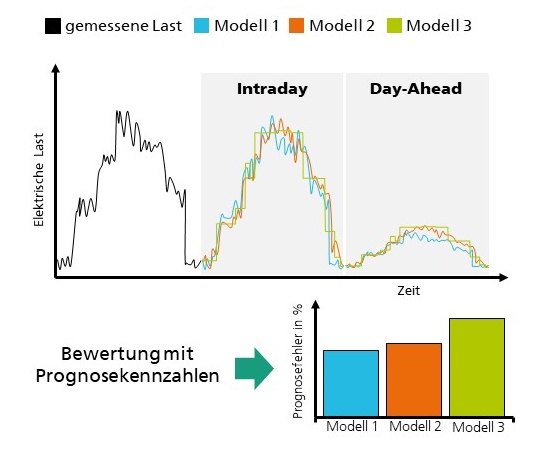

Lastprognosen gewinnen auf dem Energiemarkt der Zukunft an Bedeutung. Nur durch die kurzfristige Vorhersage kann der Stromverbrauch an das fluktuierende Angebot angepasst werden. Auch heute gibt es schon zahlreiche Anwender aus der Energiewirtschaft. Die Prognosegenauigkeit ist entscheidend, um Fehlplanungen zu vermeiden. Die erzielbare Genauigkeit hängt sowohl von der Datenlage als auch dem Prognosemodell ab. Durch die Verwendung zusätzlicher Eingangsdaten können weitere Einflussfaktoren erfasst und damit die Prognosegenauigkeit erhöht werden. Durch einen Prognose-Benchmark können Energieversorger die Prognosemodelle, die der Dienstleister verwendet, die im beschafften Tool umgesetzt oder in einer eigenen Softwareumgebung implementiert sind, mit dem Stand der Technik vergleichen.

Der Prognose-Benchmark kann je nach den spezifischen Anforderungen konfiguriert werden, um mit verschiedenen Datenquellen oder Modellen erstellte Prognosen einheitlich zu vergleichen. Dafür ist ein repräsentativer Testzeitraum zu wählen, in dem Prognosen im Anschluss der Modellkalibrierung simuliert werden. Zur Quantifizierung der Prognosegenauigkeit dienen gängige Bewertungskennzahlen. Somit lassen sich Aussagen treffen, wie akkurat Prognosemodelle für den betrachteten Anwendungsfall sind. Die Prognosegenauigkeit und die Betrachtung weiterer Kriterien ist die Entscheidungsgrundlage für Energieversorger zur Wahl eines Prognosemodells beziehungsweise eines Dienstleisters oder eines Systemanbieters.

Referenzen

[1] Michael Fiedeldey, Analyse und Prognose elektrischer Lastgangzeitreihen, Cuvillier Verlag, Göttingen, 2010

[2] Alexander Sauer, Eberhard Abele, Hans Ulrich Buhl, Energieflexibilität in der deutschen Industrie, Ergebnisse aus dem Kopernikus-Projekt Synergie, 2020

[3] Patrick Kronig et al., Schlussbericht ELBE – Validierung und Verbesserung von Lastprognosen, Schweizerische Eidgenossenschaft (Bundesamt für Energie BFE), Bern, 2009

[4] Feras Alasali et al., Day-ahead industrial load forecasting for electric RTG cranes, Journal of Modern Power Systems and Clean Energy, Feb. 2018

[5] Bastian Dietrich et al., Machine learning based very short term load forecasting of machine tools, Applied Energy, Okt. 2020

[6] Wolfgang Schellong, Analyse und Optimierung von Energieverbundsystemen, Springer, Berlin/Heidelberg, 2016

[7] Gesellschaft für Energie und Klimaschutz Schleswig-Holstein GmbH, Optimierung der Fahrplanprognose für die Beschaffung elektrischer Energie durch Einsatz messtechnisch ermittelter Kundenlastgänge anstelle von Standardlastprofilen

[8] Thilo Walser et al., Readiness of Short-term Load Forecasting Methods for their Deployment on Company Level, Proceedings of Grid Service Market, Okt. 2020, S. 89 – 103

[9] Frederik Scheidt et al., Data analytics in the electricity sector – A quantitative and qualitative literature review, Energy and AI, Aug. 2020

Ihr Ansprechpartner

Christian Schneider

Forschungsteamleiter Datengetriebene Energiesystemoptimierung Telefon: +49 711 970-3640