Quelle: Fraunhofer IPA/Grafik: Andrine Theiss

Autonome Auftragssteuerung mit Reinforcement Learning

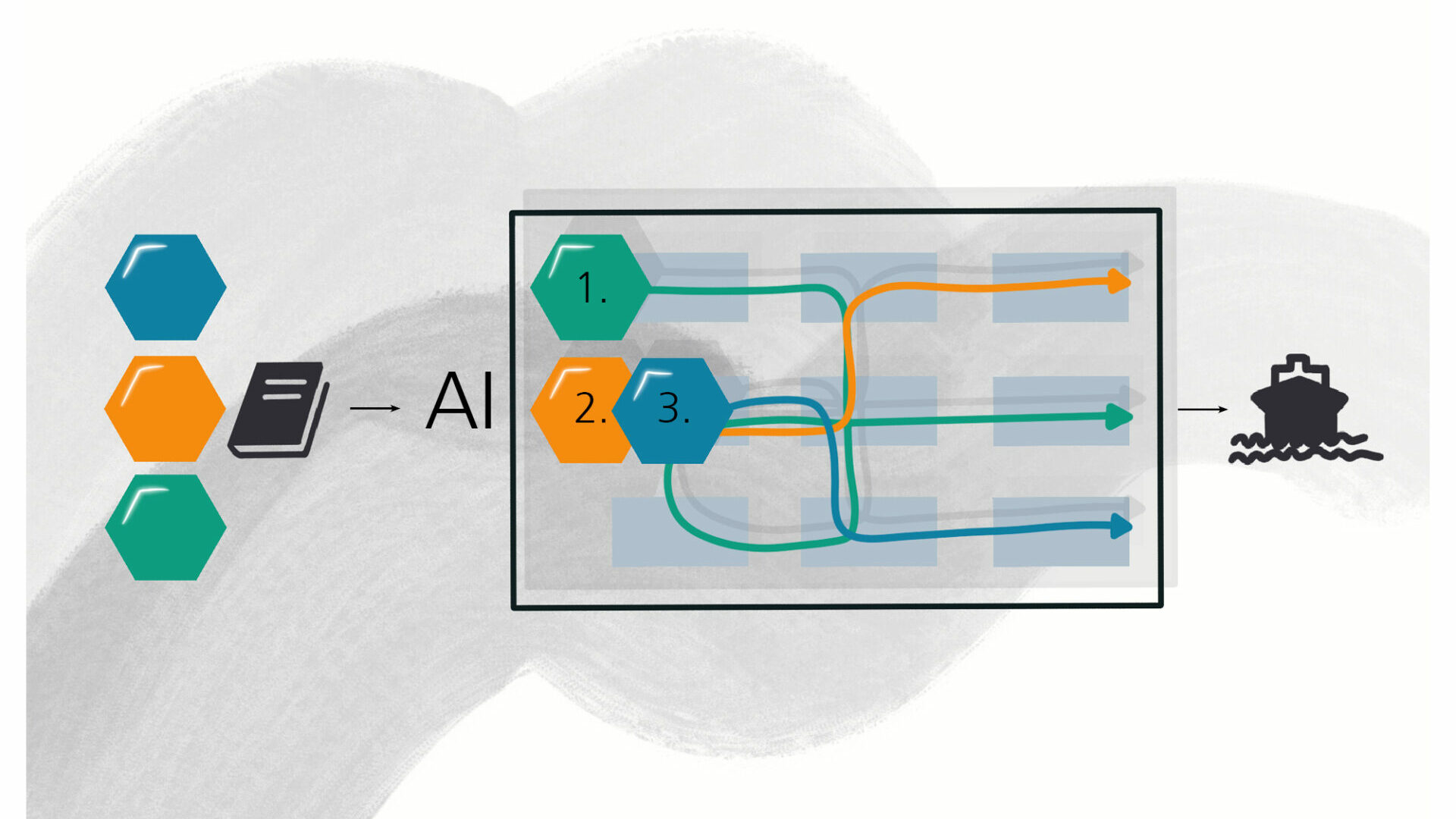

Kundenaufträge so steuern, dass auf Umweltänderungen in Echtzeit reagiert werden kann und gleichzeitig logistische Zielgrößen wie Produktionskosten, Durchlaufzeit oder Termintreue optimiert werden. Dies ist die Zielsetzung, die ein Team am Fraunhofer IPA mit Methoden der Künstlichen Intelligenz erreichen möchte.

Veröffentlicht am 02.06.2022

Lesezeit ca. 5 Minuten

Reinforcement Learning in der Produktion

Das Teilgebiet der Künstlichen Intelligenz, das im Forschungsprojekt »Selbstlernende Steuerung einer technologieübergreifenden Matrixproduktion durch simulationsgestützte KI« (SE.MA.KI) für die Auftragssteuerung genutzt wurde, ist das sogenannte Reinforcement Learning (RL). RL konnte bereits publikumswirksam in Video- und Strategiespielen beeindruckende Erfolge erzielen, indem es sequentielle Entscheidungsprobleme löste. Diese Grundlagenforschung schafft nun die Basis für die Nutzung von RL bei realen Entscheidungsproblemen in der Produktionsplanung und -steuerung.

RL funktioniert über einen belohnungsorientierten Algorithmus: Ein Agent interagiert mit seiner Umwelt und wird in Abhängigkeit der gewählten Aktionen für sein Verhalten belohnt. Durch die Maximierung der Belohnung erlernt der Agent erfolgreiche Strategien. Im Gegensatz zu anderen KI-Verfahren des überwachten Lernens, generiert der Algorithmus seine Trainingsdaten durch die Interaktion mit der Umwelt selbst.

Warum ist die Steuerung von Aufträgen in der Matrixproduktion so komplex?

Im Gegensatz zur klassischen Linienproduktion ist der Produkt- und Materialfluss in hochflexiblen Produktionssystemen wie der Matrixproduktion nicht durch das Produktionssystem vorgegeben. Dadurch lassen sich kundenindividuelle Produkte wirtschaftlich fertigen. Gleichzeitig steigt aber auch die Komplexität der Steuerung und unvorhergesehene Ereignisse in der Auftragsabwicklung nehmen zu.

Klassische Verfahren der Auftragssteuerung wie Heuristiken sind daher nicht geeignet, um diese hochflexiblen Produktionssysteme effizient zu steuern. Selbstlernende Auftragssteuerungssysteme sind in der Lage, diese Lücke zu schließen. Zum einen kann durch das konstante Lernen auf Umweltveränderungen reagiert werden und zum anderen können die Neuronalen Netze der RL-Algorithmen komplexere Strategien abbilden.

Herausforderungen bei der autonomen Auftragssteuerung

Um die Algorithmen anzulernen, werden Simulationsmodelle verwendet, die ein digitales Abbild des zu steuernden Produktionssystems darstellen. Die erlernte Strategie hängt dabei maßgeblich von der Formalisierung des Lernproblems ab. Einerseits ist die Ausgestaltung der Belohnungsfunktion relevant, die entsprechend der relevanten logistischen Zielgrößen, wie beispielsweise den Produktionskosten oder der Durchlaufzeit, definiert werden muss.

Andererseits bedingen die Größe und Gestalt des Zustands- und Aktionsraums die Auswahl und Ausgestaltung der Algorithmen. Der Zustandsraum beschreibt dabei die Menge aller möglichen Zustände, in denen sich das Produktionssystem befinden kann. Der Aktionsraum beschreibt den Handlungsspielraum, den der Agent zur Steuerung der Produktion hat. Im Projekt wurden daher folgende Fragestellungen erforscht:

- Wie können bestehende Simulationsmodelle erweitert werden, damit diese als Lernumgebung für autonome Auftragssteuerungssysteme dienen können?

- Wie kann die Auftragssteuerung in der Matrixproduktion als RL-Lernproblem dargestellt werden?

- Wie kann bestehendes Modellwissen des Digitalen Zwillings zur Planung in den Trainingsprozess integriert werden, um dateneffizientes Lernen mit Suchalgorithmen wie beispielsweise »Monte Carlo Tree Search« (MCTS) zu ermöglichen?

Zur Beantwortung dieser Forschungsfragen wurde eine Lernumgebung entwickelt. Erste Ergebnisse zeigen, dass, mit der RL-basierten Auftragssteuerung für die Matrixproduktion bessere Ergebnisse erzielt werden können als mit gängigen Heuristiken, wie beispielsweise der FIFO-Logik (»First-in-First-out«).

Ausblick

Die im Rahmen des Projekts verwendete Lernumgebung wird auf eine allgemeinere Eignung hin erweitert und die entwickelten und angepassten Algorithmen auf ihre Befähigung getestet, ob eine optimale Steuerung erreicht werden kann. Im Anschluss wird analog dazu eine Simulation erstellt, die eine real existierende Produktionsumgebung so abbildet, dass die Auftragssteuerung an einem praktischen Anwendungsfall evaluiert werden kann.

Die erfolgreiche Implementierung und Integration einer Künstlichen Intelligenz in reale Produktionsumgebungen hängt von weiteren, teils unbekannten Einflussfaktoren, ab. Daher besteht auch über das Projekt hinaus anwendungsnaher Forschungsbedarf an den untersuchten Fragestellungen.

Serie zur Matrixproduktion

Eine Serie von Beiträgen beschäftigt sich auf interaktiv online mit der Matrixproduktion, einem flexiblen Produktionssystem, das Resilienz und Wandlungsfähigkeit eines Unternehmens erhöht. Erschienen ist in dieser Serie bereits:

- Kein Fehler in der Matrix von Daniel Ranke

- Zuverlässige Durchlaufzeitprognose in der Matrix von Lisa Charlotte Günther

- Automatisierte Prozesskontrolle in der Matrix von Hang Beom Kim und Timo Leitritz

- Selbstlernende Roboter – die matrixfähige Montagezelle von Arik Lämmle

- Prozessablauf zur Rekonfiguration von Matrix-Produktionssystemen von Michael Trierweiler

- Maschinelles Lernen ermöglicht matrixfähige Kommissionierzelle von Felix Spenrath und Richard Bormann

Nächsten Monat zeigen Christoph Haar und Hang Beom Kim, wie fertigungsrelevante Informationen in 2D-Zeichnungen automatisch erkannt und verarbeitet werden können.

Dieser Artikel ist im Rahmen von »SE.MA.KI« (Selbstlernende Steuerung einer technologieübergreifenden Matrixproduktion durch simulationsgestützte KI) entstanden. Das Forschungs- und Entwicklungsprojekt SE.MA.KI. wird vom Bundesministerium für Bildung und Forschung (BMBF) gefördert. Förderkennzeichen: L1FHG42421. Die Verantwortung für den Inhalt dieser Veröffentlichung liegt beim Autor.

Ihr Ansprechpartner

Tobias Heinrich Nagel

Mitarbeiter des Forschungsteams Effiziente Lern- und Optimierungsverfahren

Telefon: +49 711 970-1962