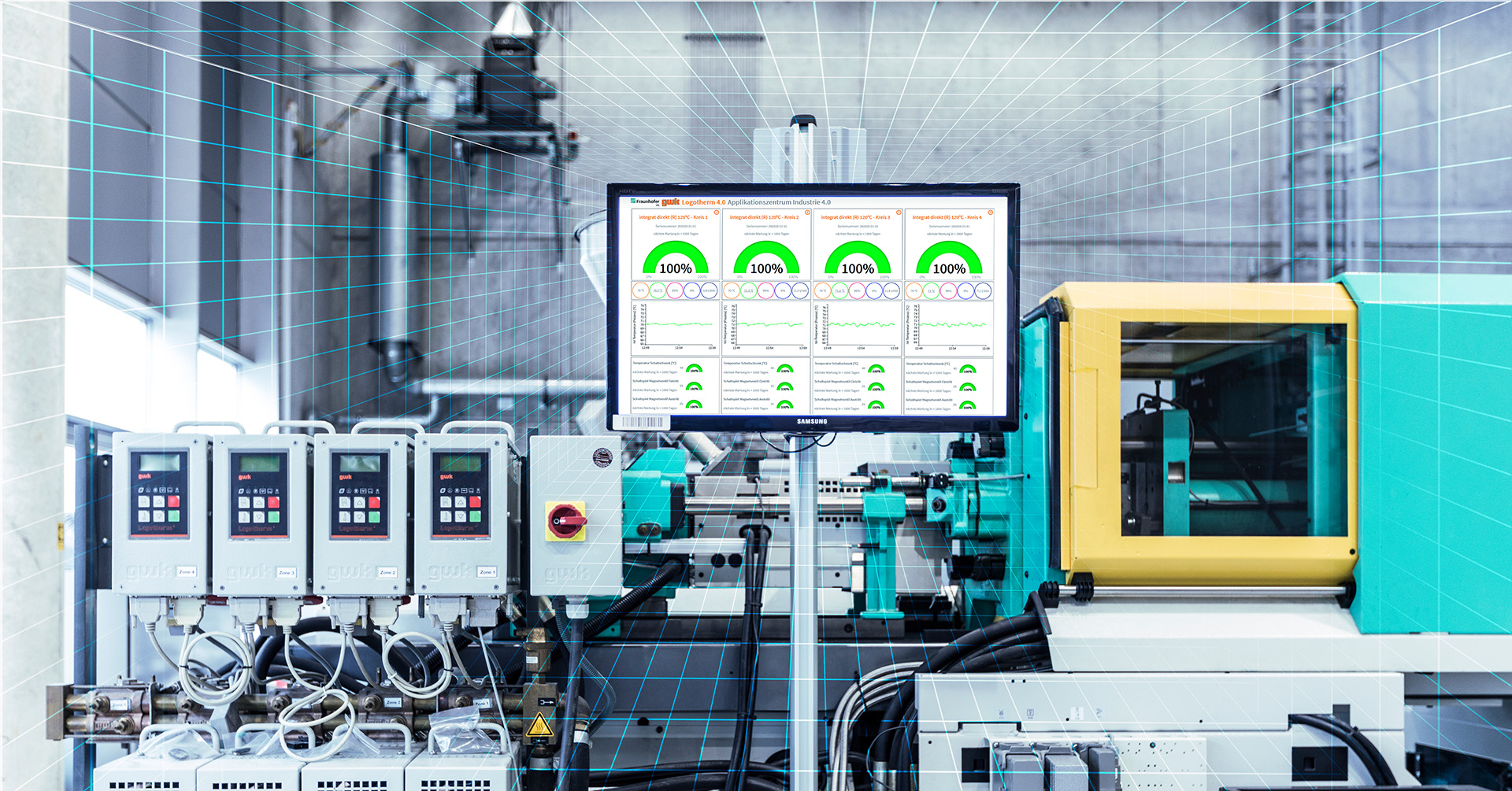

Quelle: Universität Stuttgart IFF/Fraunhofer IPA, Foto: Rainer Bez

Transformative Kraft: Generative KI in der Produktion

Generative KI-Tools wie ChatGPT haben in sehr kurzer Zeit ihr revolutionäres Potenzial in vielen privaten wie beruflichen Kontexten gezeigt. Auch in der Produktion werden sie Auswirkungen haben und einen Mehrwert bieten. Das Fraunhofer IPA begleitet Unternehmen von der ersten Einsatzidee bis zur Evaluation bereits etablierter Anwendungen.

Veröffentlicht am 08.08.2024

Lesezeit ca. 11 Minuten

Meist schon reflexhaft wird der 30. November 2022 als »iPhone-Moment« der Künstlichen Intelligenz (KI) bezeichnet. Und das durchaus zu Recht: Die Vorstellung von ChatGPT durch die Firma OpenAI hat das KI-Teilgebiet generativer Tools in rasantem Tempo einer riesigen Zielgruppe zugänglich gemacht, ohne dass man dafür ein spezielles Fachwissen braucht. Ganz ähnlich eben, wie es im Jahr 2007 für das iPhone galt, das Handys mit Bedienung über den Touchscreen sehr schnell zum technischen Standard machte und völlig neue Anwendungen ermöglichte.

Generative KI ist gekommen, um zu bleiben. Das steht fest. Seit der Einführung von ChatGPT hat sich bereits sehr viel getan. Das grundsätzlich Neue ist, dass generative KI nicht mehr nur bestehende Daten analysiert und daraus Regeln und Aktionen ableitet, sondern dass bisher nicht vorhandene Dinge wie Text und (Bewegt-)Bild erzeugt werden können. Diese Texte sind mitunter so gut, dass sie von menschlicher Sprache nicht mehr zu unterscheiden sind.

Riesiger Sprung in der Sprachverarbeitung

Ein kurzer Blick in die Historie der natürlichen Sprachverarbeitung zeigt, welch großer Sprung sich Ende 2022 getan hat, als ChatGPT allgemein verfügbar wurde. Die Geschichte der natürlichen Sprachverarbeitung lässt sich grob in zwei Hauptströmungen unterteilen, die teilweise bis in die 1950er Jahre zurückreichen: die regelbasierte beziehungsweise symbolische und die lernbasierte beziehungsweise statistische Strömung. Die regelbasierte Strömung, die auf linguistischen Regeln sowie einem Thesaurus basiert, war in früheren Jahrzehnten dominant und kam in verschiedenen Anwendungsbereichen zum Einsatz. Ein berühmtes Beispiel hierfür ist der Chatbot Eliza aus dem Jahr 1966, der zugleich die Grenzen dieser Technologie aufzeigt und noch heute online verfügbar ist.

Die zweite, lernbasierte Strömung nutzt maschinelle Lernverfahren, die sich weit über einfache statistische Berechnungen von Buchstaben- oder Wortfolgen hinaus entwickelt haben. Diese Ansätze nutzen komplexe Modelle und Algorithmen, um aus großen Datenmengen zu lernen und Sprache in einer Weise zu verarbeiten, die frühere Technologien übertrifft. Der besagte Sprung im Jahr 2022 bezieht sich auf die allgemeine Verfügbarkeit von ChatGPT, einem Modell, basierend auf der neuesten Generation der Transformer-Architektur. Dies markierte einen signifikanten Fortschritt in der Zugänglichkeit und Anwendbarkeit von hochentwickelten Sprachmodellen für eine breite Öffentlichkeit.

Diese sogenannte Transformer-Architektur (Generative Pretrained Transformer = GPT) hat Google Brain 2017 entwickelt. Mithilfe dieser Architektur wird ein »Large Language Model« (LLM) mit einer riesigen Menge an Parametern trainiert. Bei ChatGPT-4 sind das 175 Milliarden, was eine enorme Rechenkapazität der zugrundeliegenden Hardware erfordert. Diese mächtige Zahl an Parametern und die Verfügbarkeit von Textdaten im Internet ermöglichen die beeindruckende Performance von Sprachmodellen. Gibt man die richtigen »Prompts« ein, also Fragen oder Eingabeaufforderungen, erhält man umfängliche und mindestens sprachlich auch korrekte Antworten. Sie lassen sich dann dialogisch mit weiteren Prompts verfeinern.

Multimodal und aufgabenunabhängig

Dabei ist ChatGPT nicht auf Text beschränkt, sondern kann in der vierten Version multimodal agieren und auch Bilder erzeugen. Ein weiterer Vorteil ist seine Aufgabenunabhängigkeit. Mit der Kernfunktionalität, Zusammenhänge in Bildern und Texten zu verstehen und darauf passend reagieren zu können, eignet es sich für diverse Aufgabenbereiche. So beeinflussen aktuell etwa 75 Prozent der generativen KI-Anwendungen vier Unternehmensbereiche: Marketing und Vertrieb, Softwareentwicklung, Kundenservice sowie Forschung und Entwicklung. Besonders betroffen sind Tätigkeiten, die sich auf Datenanalyse, die Erstellung von Marketinginhalten oder die Erforschung von Kunden- und Wettbewerbsinformationen beziehen.

Im Marketing und Vertrieb kann generative KI beispielsweise zur Erstellung personalisierter Inhalte genutzt werden, in der Softwareentwicklung Programm-Codes schreiben, Jahresberichte verfassen und überprüfen und schließlich auch in Kundensupport-Chatbots integriert werden, um Anfragen zügig und effizient zu beantworten, was die Kundenzufriedenheit verbessern kann. Besonders Führungskräfte nutzen generative KI bereits sehr intensiv als eine Art Co-Piloten in ihrem Alltag. Laut Umfrageergebnissen verwenden bereits 37 Prozent der Führungskräfte generative KI mindestens wöchentlich.

Der Fokus liegt also aktuell eher auf der »White-Collar-Welt«, dem Büroumfeld. Von einer sogenannten »Artificial General Intelligence«, einer allgemeinen starken KI hingegen ist jedoch auch generative KI noch weit entfernt, da eine solche starke KI weit mehr können müsste als Daten auszugeben.

Das bedeutet jedoch nicht, das generative KI nicht auch im Produktionsumfeld einiges umkrempeln dürfte beziehungsweise dies schon partiell tut. Die Einsatzmöglichkeiten sind hier entlang des gesamten Produktlebenszyklus zu finden: vom Design über die Produktionsplanung, die Produktion und Qualitätssicherung bis hin zum Lagern, Liefern und gegebenenfalls auch Wiederverwerten. In der Entstehungsphase kann generative KI dabei unterstützen, Kundenanforderungen aufzunehmen, Konzepte zu entwickeln oder Angebote zu erstellen. In der Betriebsphase hilft es bei der Programmierung und Inbetriebnahme des Produktionsprozesses, kann Anomalien im Betrieb erkennen, die Wartung planen oder Ersatzteile automatisiert nachbestellen. Und schließlich lassen sich in der Verwertungsphase Demontagen unterstützen oder auch der Restwert für den Rückkauf berechnen.

Mehrwerte für die Produktion

Wie Einsatzmöglichkeiten konkret aussehen können, zeigen die folgenden Beispiele. So kann generative KI insbesondere das Potenzial der Bildverarbeitung für Qualitätssicherungsaufgaben stärken. Im Rahmen des Projekts »DT-GAN« des Fraunhofer IPA und der Robert Bosch GmbH kommt die Technologie beispielsweise zur besseren Erkennung von Defekten in der industriellen Produktion zum Einsatz. Denn damit ein Algorithmus Fehler an Bauteilen erkennen kann, muss er mit möglichst vielen Beispielfotos trainiert werden.

Oft liegen hierfür jedoch nicht genügend Trainingsdaten vor, da Fehler in der Produktion (glücklicherweise) zu selten auftreten. Die generative KI bereichert einen Bilddatensatz für das Training eines KI-Modells mit synthetisch erzeugten Defektbildern, um die Klassifikationsleistung zu steigern und Defekte zuverlässiger zu erkennen. Auf diese Weise können Defekte identifiziert werden, für die nur begrenzte Trainingsdaten vorliegen, und der KI-Anwendung genügen wenige reale Defektbilder. Zudem ist die Bildgenerierung für die Fabrikplanung nutzbar, wo beispielsweise KI-basiert ein Digitaler Zwilling in 3D für die Layoutplanung oder -anpassung entstehen könnte.

Ein weiteres prädestiniertes Einsatzgebiet ist die Software-Entwicklung und -Dokumentation. Code ist stark formalisierter, strukturierter Text und liegt umfassend online vor, sodass eine KI damit ideal lernen kann. Man könnte sogar sagen, dass solch KI-basiert erzeugter Code eine Menge Schwarmintelligenz enthält, weil er auf so vielen vorhandenen Codezeilen aufbaut. Das bedeutet allerdings keinesfalls, dass die Software-Entwicklung gänzlich automatisierbar wäre. Denn nach wie vor bleibt der Mensch in der Verantwortung. Der Code muss also geprüft, getestet und eventuell korrigiert werden.

Eine Untersuchung des Portals Github für die Software-Entwicklung und -Verwaltung kam in diesem Kontext zu dem Ergebnis, dass mithilfe von generativer KI die Code-Erzeugung zwar deutlich schneller geht, die Qualität des Codes allerdings leidet. Unzählige weitere Anwendungsfelder rund um Textgenerierung bestehen beispielsweise für die Maschinenbedienung, Dokumentationen, Zusammenfassungen und vieles mehr. So lassen sich mitunter irrwitzige Zeitersparnisse erzielen. Auch für das Erzeugen von Code für die Robotik oder speicherprogrammierbare Steuerungen (SPS) ist generative KI ein attraktives Tool.

Halluzinierende Papageien?

Und doch ist beim Thema generative KI mitnichten alles auf gutem Wege. Ein großes Problem ist, dass die erzeugten Ergebnisse aktuell noch häufig inkonsistent, unlogisch oder faktisch falsch sind und das sowohl bei Text- als auch bei Bildausgaben. Die Leistungsstärke von generativen KI-Tools kann schnell den Eindruck hinterlassen, dass das System tatsächlich versteht, was es als Ergebnis ausgibt. Ein solches Weltwissen oder Bewusstsein fehlt den Algorithmen aber natürlich völlig und die Technologie verfügt weder über ein Weltmodell noch über ein Verständnis für die erzeugten Inhalte. In diesem Zusammenhang wird oftmals das Bild des »stochastischen Papageis« herangezogen, der zwar in der Lage ist, menschlich wirkende Sprache zu erzeugen, aber den tatsächlichen Sinn nicht begreift. Kommt es zu fehlerhaften Ausgaben, nennt man diese auch Halluzinationen.

Die Informationsverarbeitung von KI-Modellen unterscheidet sich erheblich von der menschlichen. Obwohl LLMs neue Textstrukturen und Ideen generieren können, haben sie kein echtes Verständnis der zugrunde liegenden Bedeutung und Kontexte. Man spricht hier von fehlender Emergenz. Ihre »Erkenntnisse« sind nicht das Ergebnis von bewusster Reflexion oder physischer Interaktion mit der Welt, da sie keine physische Präsenz oder Körper haben. Diese wären aber für die Bildung intelligenten Verhaltens und für das Lernen essenziell. LLMs zeigen daher eine Art von »synthetischer Emergenz«, indem sie neue Kombinationen und Perspektiven aus bestehenden Daten generieren. Echter wissenschaftlicher Fortschritt und tiefe neue Erkenntnisse erfordern jedoch oft ein Verständnis, das über die rein statistische Verarbeitung von Daten hinausgeht. LLMs haben beeindruckende Fähigkeiten zur Mustererkennung und Generierung von neuen Texten, aber sie sind dennoch in ihrer Fähigkeit eingeschränkt, tiefgehende, originäre Erkenntnisse zu entwickeln, die echte Emergenz im menschlichen Sinne darstellen.

Qualitative und rechtliche Absicherung notwendig

Insofern ist es umso wichtiger, dass gerade in kritischen Einsatzbereichen wie Produktionen qualifizierte Personen die KI-generierten Ausgaben überprüfen. Für Software-Code gibt es mittlerweile gute Tools, die den Code automatisiert auf Richtigkeit prüfen, was auch unbedingt genutzt werden sollte. Schon schwieriger ist es bei der Ausgabe von normalsprachlichem Text. Hier müsste man das KI-Tool dazu bringen, seine Quellen offenzulegen, damit die Informationen überprüft werden können. Das funktioniert aber aktuell noch nicht sehr gut. Es bleibt der gesunde und kritische Menschenverstand mit seinem Weltwissen, um den so wichtigen Qualitätscheck der generierten Ausgabe durchzuführen.

Weiterhin sind noch viele rechtliche Fragen im Zusammenhang mit der Nutzung generativer KI ungeklärt. Ein wichtiges Thema ist hier der Datenschutz. Denn viele Unternehmen möchten oder dürfen keine internen Daten in öffentlich verfügbare Tools mit Servern im Ausland hochladen. Oder es mangelt den öffentlichen Tools an unternehmensspezifischen Informationen, um Anfragen passend bearbeiten zu können. Entsprechend lässt sich bereits beobachten, dass private wie öffentliche Einrichtungen beginnen, unternehmensspezifische Modelle zu entwickeln. Das geht dann auch damit einher, bestehende Modelle zu verkleinern oder direkt auf »Lean«-Modelle zu setzen, die auf ein spezifisches Einsatzgebiet zugeschnitten sind und dann entsprechend auch weniger rechenintensiv sind.

Nicht zuletzt besteht rund um KI-Technologien aktuell noch eine starke Abhängigkeit Europas. Denn die zwei wichtigsten Bibliotheken stellen aktuell Google und Meta/Facebook bereit (Tensorflow und Pytorch). Würden die Unternehmen den Zugriff hierauf plötzlich limitieren oder einstellen, wäre das extrem problematisch, weil es in Europa (noch) nichts Vergleichbares gibt. Das wäre in etwa so, wie wenn ein Taxifahrer sein Auto nicht mehr nutzen könnte. Eine zentrale Technologie bräche weg. Mit ChatGPT ist es aktuell ähnlich. Bleibt zu hoffen, dass die vieldiskutierten Entwicklungen der Unternehmen Aleph Alpha aus Deutschland und Mistral aus Frankreich hier aufholen können.

Ausblick

Unstrittig ist das riesige Potenzial, das mit generativer KI auch speziell in der Produktion einhergeht. Am Ende geht es gerade in diesem Umfeld aber viel um Mechanik und physische Tätigkeiten. Sie dürften auch künftig von generativer KI weitgehend unberührt bleiben. Für alles Übrige empfiehlt es sich unbedingt, sich mit dem Thema intensiv zu beschäftigen und individuelle Einsatzszenarien auszuloten. Vonseiten des Fraunhofer IPA gibt es hier ein umfangreiches Angebot. Es reicht vom Identifizieren von Einsatzpotenzialen über das Prüfen interner Voraussetzungen und Möglichkeiten sowie der Implementierungsbegleitung bis hin zur Evaluation von Einsätzen generativer KI-Tools.

Oder, um die Frage, warum produzierende Unternehmen generative KI einsetzen sollten, von ChatGPT beantworten zu lassen: »Insgesamt kann der Einsatz generativer KI in produzierenden Unternehmen dazu beitragen, die Effizienz, Innovation und Wettbewerbsfähigkeit zu steigern, indem sie komplexe Probleme löst, Kosten senkt und die Produktqualität verbessert. Es ist jedoch wichtig, dass Unternehmen die Potenziale und Herausforderungen dieser Technologie sorgfältig evaluieren und eine maßgeschneiderte Strategie für ihre spezifischen Anforderungen entwickeln.« Dem ist auch mit gesundem Menschenverstand nichts hinzuzufügen.

Ihr Ansprechpartner

Christof Nitsche

Leiter Forschungsteam Generative KI

Telefon: +49 711 970-1665