Quelle: Fraunhofer IPA/Foto: Rainer Bez

Zuverlässige KI: Künstliche neuronale Netze absichern

Künstliche Intelligenz (KI) bietet im Produktionsumfeld viele Mehrwerte – vorausgesetzt, die verwendeten Methoden sind sicher, verlässlich und transparent. Am Fraunhofer IPA arbeiten Forscher daran, dass KI-basierte Technologien diese Kriterien erfüllen. Mit zuverlässiger KI handeln Unternehmen rechtssicher und gewinnen das Vertrauen der Anwender in die Technologie.

Veröffentlicht am 16.12.2021

Lesezeit ca. 8 Minuten

Nicht erst seit gestern sind Methoden der Künstlichen Intelligenz auf dem Vormarsch. Tatsächlich reicht ihre Historie sogar bis in die 1950er Jahre und zum bekannten Turing-Test zurück. Hierbei stellt eine Person einer menschlichen und einer künstlichen Intelligenz Fragen und versucht, anhand der Antworten zu erkennen, bei welcher Entität es sich um KI handelt. Zwar geht der Test bislang noch selten zugunsten der Maschine aus. Doch Künstliche Intelligenz, genauer: ihr prominentes Teilgebiet maschinelles Lernen (ML), ist extrem im Kommen – auch im Produktionsumfeld.

Der aktuelle Erfolg hat dreierlei Gründe. Zum einen liegen durch die Digitalisierung und Vernetzung Daten, die Grundlage für maschinelle Lernverfahren, in rauen Mengen vor. Zum anderen steigt die Rechenleistung nahezu exponentiell, um Berechnungen basierend auf den großen Datenmengen durchzuführen. Und schließlich gibt es immer performantere Algorithmen, nicht zuletzt auch durch umfassende Open-Source-Entwicklungen.

Aufkommende Herausforderungen

Dadurch, dass ML immer mehr in die Anwendung kommt, zeigen sich neben Vorteilen auch kritische Punkte. Da maschinelle Lernverfahren im gewissen Rahmen und basierend auf vorliegenden Daten eigenständige Entscheidungen treffen, kann es dabei auch zu Ergebnissen kommen, die den Menschen benachteiligen oder sogar gefährden könnten. Hierzu gibt es einige berühmt-berüchtigte Beispiele wie ein Auswahlverfahren im Bewerbungsprozess, das männliche gegenüber weiblichen Bewerbern bevorzugte. Traurige Popularität erlangte auch ein Twitterbot, dem Nutzer gezielt rassistisches Verhalten antrainieren konnten. Unfälle mit autonom fahrenden Autos oder falsche medizinische Diagnosen sind dann die Spitze des Eisbergs an schadhaften Ergebnissen, die es unbedingt zu unterbinden gilt.

Einige dieser Probleme werfen ethische Fragen auf und bedürfen einer speziellen Herangehensweise. Im Fokus der Forscher am Fraunhofer IPA stehen sicherheitsrelevante Aspekte einer KI. Unter dem Sammelbegriff der »Zuverlässigen KI« beantworten sie Fragen wie: »Ist die KI sicher gegenüber Angriffen, Unfällen und Fehlern?«, »Funktioniert die KI zuverlässig und ist sie robust?« oder »Sind Funktionsweise und Entscheidungen der KI nachvollziehbar?« Dies sind allesamt Kriterien, die auch im Produktionskontext eine große Rolle spielen und über den Einsatz von KI im eigenen Unternehmen entscheiden können. Mithilfe verschiedener Verfahren kann eine zuverlässige KI umgesetzt werden, die sowohl Rechtssicherheit schafft als auch aufseiten der Mitarbeiter für Vertrauen und Akzeptanz hinsichtlich der Technologie sorgt.

Verifikation

Beim maschinellen Lernen geht es um das Lernen anhand von Mustern in Daten. Häufig passiert dies mithilfe von künstlichen neuronalen Netzen, also Algorithmen, deren Strukturen die Funktionsweise des menschlichen Gehirns mit Nervenzellen nachbilden. Bestehen diese neuronalen Netze aus besonders vielen Schichten, spricht man von »Deep Learning« oder tiefen neuronalen Netzen.

Entscheidend für die Ergebnisqualität beim Deep Learning ist die Datengrundlage. So konnte eine Gruppe internationaler Wissenschaftler 2017 zeigen, dass neuronale Netze für die Bildverarbeitung schon dann zu fehlerhaften Ergebnissen kommen, wenn im zugrundeliegenden Bildmaterial nur kleine Pixelanteile verändert werden, die mit dem bloßen Auge häufig nicht sichtbar sind. Es ist also mitunter leicht möglich, mit minimalem Aufwand Ergebnisse zu verfälschen. Bei den beschriebenen Pixeländerungen spricht man von »Adversarial Attacks«.

Es wäre also wichtig, die Eingabedaten hinsichtlich ihrer Qualität zu überprüfen. Da bei einem Angriff jedoch theoretisch unendlich viele Daten erzeugt werden können, ist das manuelle Prüfen ausgeschlossen. Eine Lösung hierfür ist die automatische Verifikation. Hierbei geht es darum, eine unendliche Menge an Eingabedaten abstrakt zu repräsentieren und sie daraufhin automatisch und simultan zu beurteilen. Diese Beurteilung erfolgt basierend auf Anforderungen, die die Ausgabemenge erfüllen muss. Entspricht sie diesen Anforderungen nicht, kann dies auf manipulierte Daten, aber auch auf eine mangelnde Datengrundlage oder zu wenig Training hindeuten. Dieses Vorgehen funktioniert analog zu einem mathematischen Beweis, der idealerweise korrekte und vollständige Aussagen trifft.

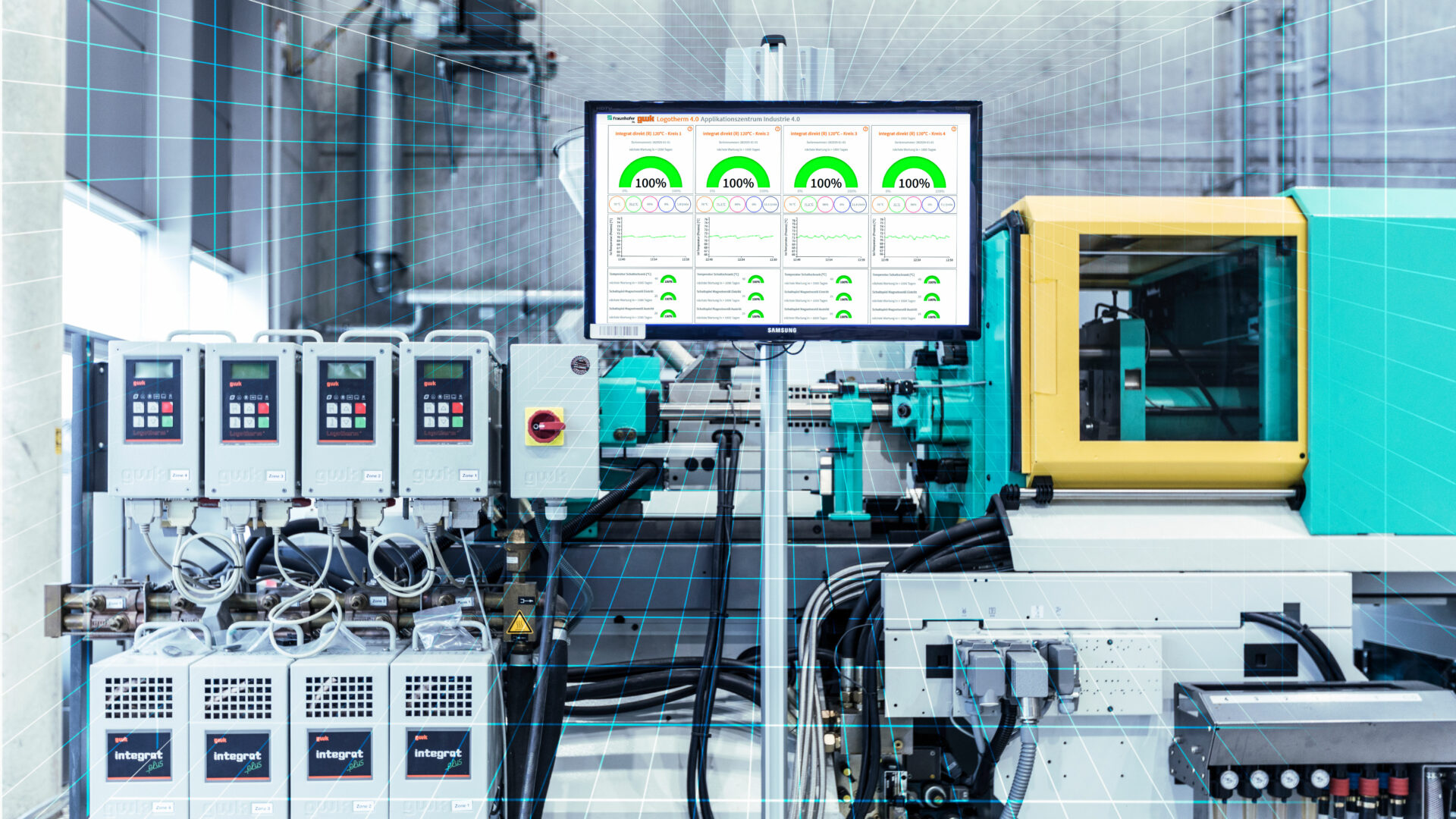

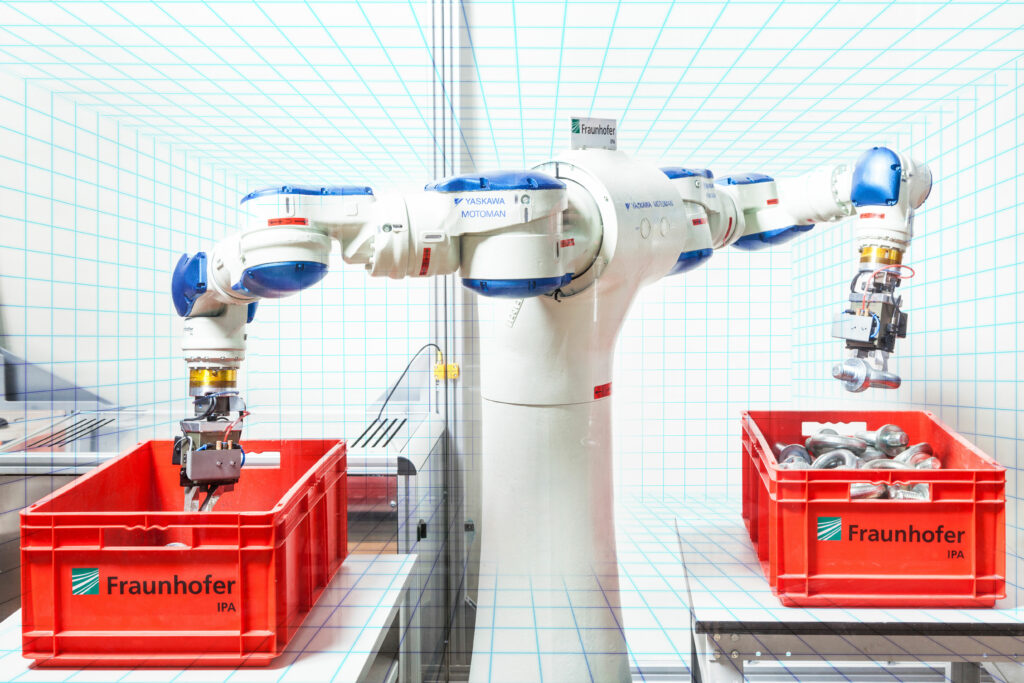

In einem Forschungsprojekt gemeinsam mit der Firma Sick und gefördert vom KI-Fortschrittszentrum »Lernende Systeme und Kognitive Robotik« konnten Wissenschaftler vom Fraunhofer IPA die Methode der formalen Verifikation anhand eines praktischen Anwendungsfalls erproben. Konkret ging es darum, zu beweisen, dass der Einsatz von Laserscannern für eine Anwendung ausreichend sicher ist. Dabei lag der Schwerpunkt auf der Verifikation des Modells, nämlich ob das Modell immer richtige Entscheidungen treffen kann, wobei »richtig« die Erfüllung vorgegebener Eigenschaften und Anforderungen meint. Um die KI-Modelle sicher zu machen, extrahierten die Wissenschaftler vom Fraunhofer IPA die sicherheitskritischen Eigenschaften, beispielsweise das Begrenzen von Arbeitsraum und Geschwindigkeit eines Roboterarms bei sich näherndem Menschen, und verwendeten dann die formale Verifikation, um mathematische und systematische Beweise zu erzeugen. Es stellte sich allerdings heraus, dass die Extraktion von Sicherheitseigenschaften aus den Laserscannerdaten herausfordernd ist. Die Skalierung auf große neuronale Netze muss optimiert werden und nur wenige Architekturen neuronaler Netze eignen sich derzeit hierfür. Hier besteht also noch Forschungsbedarf.

Verlässlichkeit und Unsicherheitsquantifizierung

Deep-Learning-Verfahren gelangen autonom zu Ergebnissen, die oft als Grundlage für Folgeschritte dienen. Für Anwender ist es entsprechend wichtig, dass die Ergebnisse korrekt und verlässlich sind. Wie fragil diese Verlässlichkeit mitunter sein kann, zeigt das Beispiel der oben beschriebenen »Adversarial Attacks« bei der Bildverarbeitung. Ein weiterer typischer Fall wäre das Erkennen von »Out-of-Distribution-Data«: Was passiert also, wenn ein Hund-Katze-Klassifikator für ein neuronales Netz trainiert wird und das Netz ausnahmsweise mit einem Elefantenbild konfrontiert wird? Ein klassisches neuronales Netz wird sich vermutlich mit starker Tendenz für Hund oder Katze entscheiden. Ein neuronales Netz mit der Möglichkeit, Unsicherheit zu bewerten, käme hingegen zu einer Ausgabe wie »Ich weiß nicht, was abgebildet ist, weil ich so ein Bild noch nie gesehen habe«. Entsprechend wichtig ist es, die (Un-)Sicherheit beziehungsweise Verlässlichkeit eines neuronalen Netzes angeben zu können.

Am Fraunhofer IPA lösen die Wissenschaftler dies mithilfe sogenannter »Bayes’scher neuronaler Netze« (BNN). Dabei werden die einzelnen Gewichte der Verbindungen zwischen den Knotenpunkten eines Netzes als Zufallsvariablen mit einer bestimmten Wahrscheinlichkeitsverteilung modelliert und während des Trainings aktualisiert. Dies sorgt für robustere Vorhersagen, da das BNN auch abschätzt, wie sicher es sich bei der Wahl der gelernten Gewichtsparameter ist. Dieses Vorgehen sorgt dafür, dass die Ausgabe des BNN einer Wahrscheinlichkeitsaussage entspricht statt der bloßen Schätzung eines einzelnen Wertes. Die Bestimmung dieser Gewichte ist allerdings herausfordernd und die Berechnung der Wahrscheinlichkeit rechnerisch schwierig. Hier muss mit Näherungen gearbeitet werden. Hinzu kommt, dass die eingesetzten Algorithmen häufig schlecht mit der Menge der Daten oder der Datendimensionalität skalieren. Und für neue oder zusätzliche Daten muss das Netz vollständig neu trainiert werden.

In einer Publikation haben Wissenschaftler vom Fraunhofer IPA eine weitere innovative BNN-Methode entwickelt, die auf dem Kalman-Filter, bekannt aus der digitalen Signalverarbeitung, basiert. Bei der Vorhersage neuer Daten kann dabei unter bestimmten Voraussetzungen fast gänzlich auf Näherungen verzichtet werden. Während des Trainings wird für jede Schicht des Netzes die ausgegebene Vorhersage mit den tatsächlichen Daten verglichen und basierend auf den zugrundeliegenden Unsicherheiten des Netzes ein Korrekturterm für die Gewichte gebildet. Diese Aktualisierung der Gewichte geschieht hierbei analog zum klassischen Kalman-Filter. Ein Vorteil der Methode gegenüber anderen Verfahren ist die Möglichkeit, kontinuierlich anhand jedes neuen Datenpunktes weiterzutrainieren. Damit eignet sich die Methode für das sogenannte Online-Training, also dem Lernen zur Laufzeit. Momentan wird die Methode, die bisher lediglich anhand tabellarischer Daten getestet wurde, für die Verarbeitung von Bilddaten erweitert.

Erklärbarkeit

Ein weiteres Kriterium für zuverlässige KI-Technologien ist, inwieweit die Algorithmen und ihre Ergebnisausgabe transparent, also für relevante Zielgruppen nachvollziehbar sind. Das ist einerseits wichtig, um Vertrauen in die Technologie und Nutzerakzeptanz zu stärken. Andererseits sind es rechtliche Vorgaben, beispielsweise die Datenschutz-Grundverordnung (DSGVO), die erfüllt werden müssen. So haben Betroffene bei einer automatisierten KI-Entscheidung das Recht zu erfahren, wie das Ergebnis zustande gekommen ist. Entsprechend relevant ist es, dass KI-Algorithmen in kritischen Anwendungen nicht wie eine sogenannte Black-Box wirken, sondern einem White-Box-Modell entsprechen, das intuitiv und gut zu verstehen ist. Um dies zu ermöglichen, entstehen am Fraunhofer IPA verschiedene Verfahren zur »Explainable AI« oder kurz »xAI«.

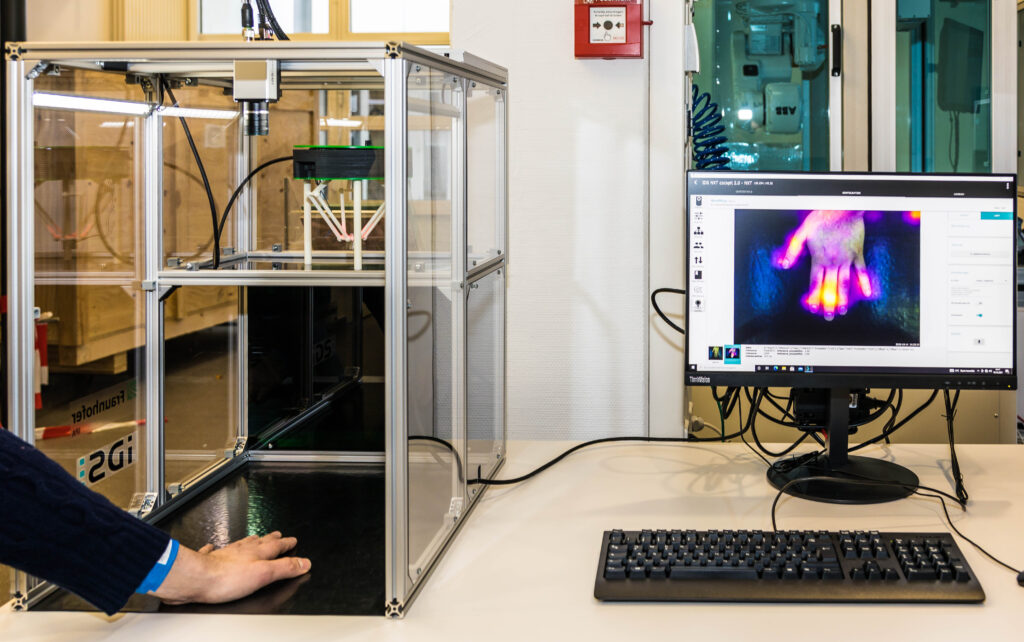

Mithilfe der Verfahren können die Experten vom Fraunhofer IPA die Entscheidungsfindung eines Algorithmus nachvollziehen und offenlegen. In der Wissenschaft gab es hier den prominenten Fall, dass eine Bilderkennungssoftware eine Lungenentzündung nicht anhand des Krankheitsbildes der Lunge klassifizierte, sondern dadurch, dass die Bilder von einem mobilen Röntgengerät aufgenommen wurden. Offenbar waren die erkrankten Patienten bettlägerig, weshalb immer das Gerät genutzt wurde. Das KI-Modell hat also eher das Gerät wiedererkannt und nicht die Krankheit. Mittels einer sogenannten »Heatmap« lässt sich anzeigen, welche Bildkomponenten besonders relevant für die Ergebnisfindung waren und so Fehler offenlegen. Denn nicht immer bedeutet Korrelation auch Kausalität.

Verfahren zur Erklärbarkeit können entweder lokal oder global funktionieren. Lokal bedeutet, sie erklären, warum eine bestimmte Eingabe zu einer bestimmten Ausgabe führt, global wie ein bestimmtes Modell als Ganzes funktioniert. Die zuvor erwähnte Heatmap ermöglicht beispielsweise lokale Erklärbarkeit. Eine Möglichkeit für globale Erklärbarkeit ist, ein interpretierbares Stellvertretermodell aus dem Netz zu extrahieren, beispielsweise in Form eines Entscheidungsbaums oder von Entscheidungsregeln. Dieses White-Box-Modell simuliert dann das Black-Box-Modell und trifft weitgehend gleiche Vorhersagen. Entscheidungsbäume bestehen aus internen Knoten, die zu überprüfende Bedingungen definieren, und Blattknoten, die Klassen darstellen. Für ein zu klassifizierendes Datum wird der Entscheidungsbaum von oben nach unten traversiert, bis man einen Blattknoten erreicht, der die Klasse codiert. Im Prinzip besteht ein Entscheidungsbaum aus vielen Wenn-Dann-Regeln. Wie dieses Verfahren genau funktioniert, veranschaulicht ein Demonstrator des Fraunhofer IPA (siehe Video), den die Wissenschaftler bereits vielen Kunden präsentiert haben. Außerdem ist eine umfangreiche Studie des Instituts zu xAI verfügbar.

Passgenaue Formate für die Zusammenarbeit

Um Unternehmen rund um das Thema zuverlässige KI individuell zu beraten und voranzubringen, bietet das Fraunhofer IPA verschiedene, teils auch finanzierte, Förderformate. Vorhandene Technologien können entsprechend den Bedarfen eingesetzt oder weiterentwickelt werden und es ist ebenfalls möglich, ganz neue Verfahren zu erstellen. Beschreiten Sie mit uns einen rechtssicheren, transparenten und maßgeschneiderten Weg mit Ihrer eigenen KI-Anwendung. Wir freuen uns auf Ihre Kontaktaufnahme.

Ihre Ansprechpartner

Marco Huber

Wissenschaftlicher Direktor für Digitalisierung und KI

Telefon: +49 711 970-1960

Philipp Wagner

Mitarbeiter des Forschungsteams Effiziente Lern- und Optimierungsverfahren

Telefon: +49 711 970-1988

Xinyang Wu

Forschungsteamleiter Effiziente Lern- und Optimierungsverfahren

Telefon: +49 711 970-3673